Aïe Aïe AI

— Octobre 2022

Un temps de réflexion, de questionnement collectif et de débat autour de quelques enjeux contemporains liés aux “intelligences artificielles” dans le champ de la création visuelle, de l’art et du graphisme.

Mise à jour

Anthony Masure, dans le cadre du projet de recherche « Design et machine learning : l’automatisation au pouvoir ? » à la HEAD, a publié Design sous artifice : la création au risque du machine learning, remarquable essai de synthèse sur les questions évoquées ci-dessous.

♫ À noter, l’essai est disponible sous forme de lecture audio.

Florie Souday et Anthony Masure ont également publié un vaste état de l’art, qui liste et commente une sélection de ressources traitant des enjeux pédagogiques des « intelligences [dites] artificielles » contemporaines.

Avertissement

☞ De nombreuses hypothèses reprises, synthétisées ou augmentées dans cette proposition se basent sur l’article et les recherches d’Olivier Ertzscheid, Une question de génération. Vers un capitalisme sémiotique et de réflexions récentes d’Étienne Mineur.

Depuis lors, l’évolution des outils a rendu pâles quelques unes des hypothèses évoquées ci-dessous. Olivier Ertzscheid a publié plusieurs articles et de nombreux autres se sont joints à l’analyse et à la critique de ces outils, désormais devenus omniprésents et dont rien ne semble devoir arrêter ou ralentir le développement. Cette introduction reste disponible, pour mémoire, et pour initier un débat qui méritera de plus amples développements.

Vocabulaire

Les termes d’apprentissage profond (Deep learning), apprentissage automatique (Machine Learning), apprentissage par renforcement (Reinforcement learning), réseaux de neurones artificiels (neural networks), réseaux antagonistes génératifs (GAN) et bien d’autres, décrivent les technologies sous-jacentes de bien des outils et services associés à la notion « d’intelligence artificielle ». Ils s’appuient pour la plupart d’entre eux sur des mécanismes d’apprentissage automatique qui n’ont que peu à voir avec ce que l’on entend communément par « intelligence »1.

La question — et la peur — de l’intelligence des machines nourrit un imaginaire largement parcouru par la science-fiction, depuis et avant Asimov2, Philip K. Dick ou James Cameron.

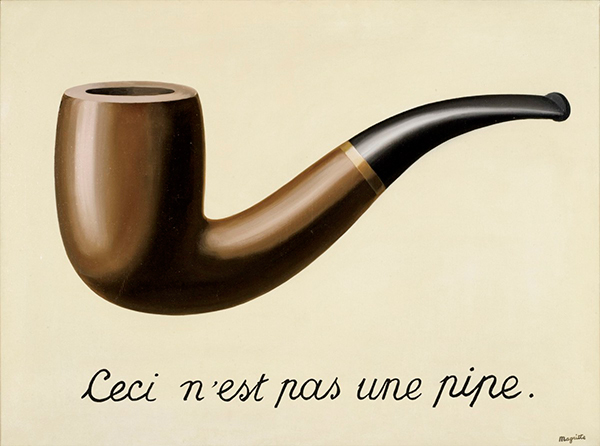

Hormis les recherches visant à produire à terme des « IA fortes », il ne s’agit pour le moment que (‽) de processus et d’outils basés sur des logiques d’apprentissage, de nouvelles manières pour les machines d’appréhender de grands jeux de données, et pas d’intelligence au(x) sens strict(s). Il s’agit surtout de simulation – de mimétisme, de faire semblant, d’imitation des résultats – de l’intelligence (à la fois rationalité et conscience) humaine. La conscience ou l’émotion ne sont encore que des processus « mimés » par les ordinateurs.

Origines

Le terme d’intelligence artificielle fut créé par John McCarthy, un des pionniers de ce champ de la recherche en informatique.

Les hypothèses autour de l’intelligence artificielle émergent dans les années 50, notamment dans l’article « Computing Machinery and Intelligence » du mathématicien et pionnier de l’informatique Alan Turing. Turing se demande alors si les machines peuvent penser, si elles peuvent atteindre un niveau de conscience. Il développe alors un « jeu », le test de Turing, visant à déterminer si un interlocuteur invisible est une machine ou un humain. Nus rencontrons régulièrement un des avatars de ce jeu dans les CAPTCHA3.

Les avancées rapides des techniques informatiques, combinées à l’augmentation de la puissance de calcul des microprocesseurs4 vont faire progressivement naître des méthodes qui vont permettre le développement de l’IA dans de nombreux domaines, de la science fondamentale jusqu’à de nombreuses applications pratiques – voire à des gadgets technologiques extrêmement coûteux en énergie et en matériel.

L’apprentissage automatique se développe dans les années 80 : l’ordinateur commence à déduire des « règles » à partir de jeux de données. On ne lui dit pas quoi faire, on lui permet de le découvrir en parcourant un grand nombre d’exemples.

Cet apprentissage peut également se produire de manière supervisée (on signale progressivement à l’ordinateur si ses déductions sont correctes). Ces démarches conduisirent par exemple à ce qu’en 1996, l’ordinateur Deep Blue, un supercalculateur d’IBM, batte le champion d’échec Gary Kasparov, dans un moment trouble et paroxystique de la lutte entre l’homme et la machine.

La recherche se développe progressivement, principalement dans le champ de l’informatique fondamentale, jusqu’aux années 2000. À ce moment, le web, les quantités phénoménales de données produites par ses utilisateurs et de nouvelles puissances et infrastructures de calcul ouvrent la voie à l’exploitation de masses de données sans précédent (big data) ; c’est l’apprentissage profond (deep learning).

Usages désormais communs (?)

Shazam est créé en 1999. Si l’outil semble trivial aujourd’hui, il repose sur une capacité d’analyse de millions de titres et de comparaison quasi-instantanée entre l’empreinte sonore capturée par le micro d’un smartphone et la base de données présentes sur les serveurs de Shazam.

Lancé en 2006, et en permanente évolution technique depuis, le service Google Traduction se basait à l’origine sur l’analyse de corpus colossaux traduits par des humains : les documents publics des Nations unies ou du Parlement européen.

En 1996, AlphaGo, successeur de DeepBlue, mais basé sur un toute autre processus d’apprentissage bat le champion de jeu de Go, Lee Sedol. En 2017, sa version suivante AlphaGo Zero, atteint un niveau encore supérieur en ne jouant (beaucoup) que contre lui-même, avec comme seules instructions les règles du Go.

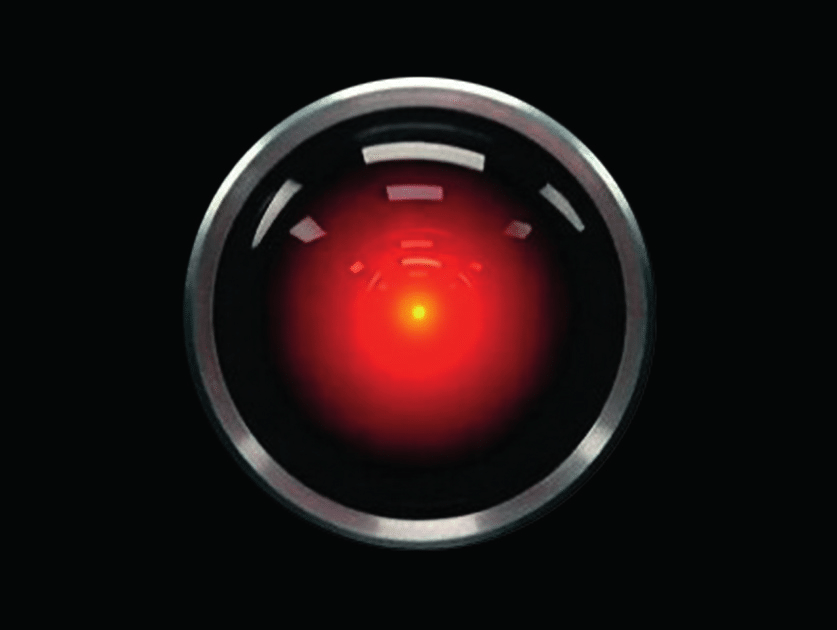

En 2010 Apple rachète et déploie Siri, un assistant vocal issu de la rencontre de plusieurs enjeux . Notamment, un projet de la DARPA visant à accroître l’efficacité décisionnelle sur le terrain militaire, associé à l’intérêt grandissant pour la commande vocale en IHM (nourri en termes d’imaginaire par des références telles que 2001, l’Odyssée de l’espace de Stanley Kubrick)5. À la même époque, IBM propose [Watson](), service d’analyse de langage naturel capable de fournir des réponses en temps réel à ses utilisateurs, notamment dans le champ de la médecine, de la finance, ou de l’analyse sémantique.

Aujourd’hui, Spotify, Amazon ou YouTube recourent à des processus algorithmiques largment appuyés sur des IA pour profiler notre écoute ou notre consommation et nous faire des propositions.

Développement dans l’art et l’image

C’est dans le courant des années 2010 que nombre d’artistes « numériques » investissent et s’approprient ces technologies.

En 2017, Gregory Chantonsky, propose de préférer le terme d’imagination à celui d’intelligence (artificielle), signalant l’intérêt de penser ces processus non pas comme anthropocentrés (machine vs humain), mais comme une multiplication des possibles, en lien avec ce qu’il nomme hyperproduction. De très nombreux projets de l’artiste sont liés à ces questions. Signalons ici un des plus récents, Disnovation V.1, dans lequel une vidéo générative s’appuie sur le moteur d’IA GPT pour produire le texte d’une interminable, incohérente et absconse conférence.

X Degrees of Separation est un projet de Mario Klingemann, artiste pionnier dans l’usage d’IA (précisément de GAN). Il met en œuvre des processus de computer vision, permettant la détection de similarités entre plusieurs images. La même année, en 2018, il propose Memories of Passersby I, une œuvre dans laquelle l’algorithme d’intelligence artificielle est le cœur du projet artistique.

Mario Klingemann, Grégory Chantonsky, Golan Levin, Memo Akten, Anna Ridler, Philipp Schmitt, Kyle McDonald, Joy Buolamwini ou Helena Sarin sont parmi les très nombreux artistes s’étant appropriés ces technologies. 6

Démultiplication récente

En 2015, Google ouvre l’accès à DeepDream, un « programme de vision par ordinateur créé par Google qui utilise un réseau neuronal convolutif pour trouver et renforcer des structures dans des images en utilisant des paréidolies créées par algorithme, donnant ainsi une apparence hallucinogène à ces images » (Wikipédia). Ce fut une émergence hypnotique et inceptionniste de l’application à des images de processus paréidoliques7, une première irruption auprès du grand public d’un outil basé sur une IA.

« Toute technologie suffisamment avancée est indiscernable de la magie »

— Arthur C. Clarke

Au cours du temps, nous avons publié sur le web, ou stocké dans le cloud, des images et des textes mis en relation. Ainsi, nous avons construit des jeux de données qui ont entraîné les algorithmes à reconnaître dans des images numériques des chats, des bus, des palmiers, des couchers de soleil, des chiffres ou des lettres (notamment via les CAPTCHAs, mais aussi grâce à nos photos de vacances). Aujourd’hui, nous sommes en mesure de retourner la question et de demander aux algorithmes à quoi ressemble un chat, un bus ou un palmier.

<avertissement> Les contenus ci-dessous se basent éhontément sur l’article et les recherches d’Olivier Ertzscheid, Une question de génération. Vers un capitalisme sémiotique., mis à disposition selon les termes de la Licence CC BY-NC 4.0 (la même que le contenu de ce site).</avertissement>

Ces derniers mois ont vu se multiplier le nombre de services (gratuits, freemium, payants) publiquement accessibles permettant d’interagir avec des IA pour leur demander des images en réponses à du texte. MidJourney, Stable Diffusion, Dall-E 2 et Dall-E mini (devenu Craiyon).

Selon leur propre descriptif il ne s’agit de rien moins que de “nouveau(x) système(s) d’IA capable(s) de créer des images et des œuvres d’art réalistes à partir d’une description en langage naturel.”

Dans son article, Olivier Ertzscheid propose les résultats d’expériences de génération d’images menées avec Midjourney, Dall-e et Stable Diffusion. Il y montre les esthétiques propres à chacun de ces outils et signale combien le « prompt », la commande en « langage naturel » qui leur est soumise peut faire l’objet de variations, via des critères pondérés, des mots-clés ajoutés. Ce faisant, il montre combien l’intervention humaine est majeure dans cette opération.

[Edit.] Moins scientifiquement, dans le blog Bootcamp de uxdesign.cc, Chris Ellinas publie The Ultimate Midjourney Cheat Sheet 2023: Copy-Paste Prompt for any Style, qui montre également assez bien l’ampleur des possibles, tout en signalant – en creux – les nombreuses limites et le systhématismes stylistiques.

Grégory Chatonsky formule des hypothèses sur l’espace latent, cet espace dans lequel existent toutes les images, passées et futures, et qu’il s’agit d’aller sonder et explorer, tel un inconscient collectif imaginable. Cette hypothèse d’un espace où tout existe, décrit par la méthaphore du singe savant8, est exploité par Borges dans sa nouvelle La bibliothèque de Babel. Il y imagine une bibliothèque dans laquelle tous les livres de 410 pages possibles existent (entendre: toutes les suites de caractères aléatoires).9

Dans un fil sur Twitter Memo Akten s’interroge sur l’hypothèse d’un « remplacement » des artistes par les IA.

Ertzscheid mentionne le travail de l’artiste turc Alper Yesiltas10 et cite une interview de lui sur le site BoredPanda :

La partie la plus difficile du processus de création pour moi est de faire en sorte que l’image me semble “réelle”. Le moment que j’apprécie le plus est celui où l’image devant moi me semble très réaliste, comme si elle avait été prise par un photographe. J’utilise différents logiciels. Le temps qu’il me faut pour créer une image entièrement terminée varie, mais je dirais qu’il faut un certain temps pour qu’une image me paraisse “réelle”.

Il signale combien « le langage est une interface qui tient à ce qu’il y a à la fois de plus rudimentaire dans l’interaction et de plus élaboré dans sa potentialisation. »

Étienne Mineur, de son côté, pointe le glissement d’une habileté gestuelle vers une habileté langagière.

Ertzscheid pose alors la question de l’autorat dans ces images : « Savoir ce qui fait œuvre, connaître la part de l’auteur et celle résiduelle ou centrale de la génération, génération qui elle-même ne se fait jamais sans “autorité” (ou autoritativité) ou sans intentionnalité… ». C’est dans une négociation, verbale ou textuelle, avec les machines que sont produits ces artefacts. On crée ainsi un espace linguistique partagé, dans « une boucle de rétroaction permanente et complexe ».

Technologies de l’artefact

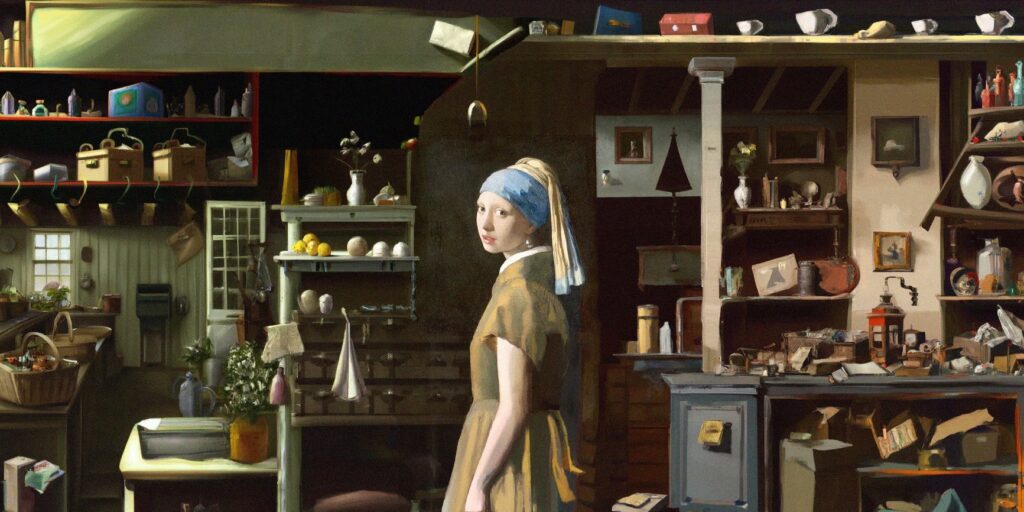

Au delà de la génération d’images via des prompts, Dall-e et Stable Diffusion proposent aussi des fonctionnalités d’inpainting et d’outpainting

Ces fonctionnalités, plus encore que la pure génération – fût-elle photoréaliste – sont « ses technologies de l’artefact […] qui rendent possible, pour l’amateur, la création de représentations volontairement altérées et artificielles de la réalité dans une recherche (une “mimesis”) de la vraisemblance. »

L’apparition et le déploiement grand-public, gratuitement ou à très faible coût de ces outils de fabrications ou d’extension d’images (aujourd’hui fixes, mais bientôt déjà vidéo) augmentent encore les questions liées à la capacité de preuve d’une image, à son régime de vérité11. Elles heurtent notre habitude à considérer images photographiques et vidéo comme vraies, notamment dans le champ médiatique (et des médias sociaux).

Capitalisme linguistique

Depuis longtemps, nous sommes habitués à voir (sans les voir) des mots vendus aux enchères : les annonces publicitaires dont Google/Alphabet, Facebook/Meta et consorts nous inondent répondent à des achats par les annonceurs de mots clés correspondants à nos empreintes numériques.

Dans l’écosystème sauvage ouvert par l’arrivée des outils d’IA, de nouveaux acteurs (tels promptbase), proposent de vendre et d’acheter des prompts : « Trouvez les meilleurs prompts, produisez de meilleurs résultats, économisez sur les coûts d’API, vendez vos propres prompts. ». L’ingénierie linguistique qu’engendrent ces relations aux machines n’a pas tardé à se monnayer.

Mais ce nouvel acteur introduit une nouvelle complexité dans la paternité de l’image produite. Qui en est l’auteur ? Est-ce le programme informatique et/ou ses programmateurs ? Est-ce le “prompteur”, celui ou celle qui a l’idée de la phrase et paramètre la critériologie correspondante ? Les auteurs des images composant le jeu de données ? Et si nous sommes les auteurs de ces images, comment sait-on que nos images y figurent et comment les en retirer ?.

Dans ces plateformes, cette question du droit est abordée de manières très différentes. Chez Midjourney, le générateur est propriétaire des images, mais Midjourney peut également utiliser images et prompts, à volonté. On y est donc surtout co-propriétaire. A l’inverse, du côté de Dall-E (OpenAI), on n’est propriétaire de rien. Chez Stable Diffusion, tout tombe en licence Creative Commons Domaine Public.

Pudeurs des machines – et de leurs détenteurs

Sur la plupart des moteurs de génération d’image, certains mots ou certaines idées sont interdites :

OpenAI vous donnera un avertissement de contenu si vous tentez de créer des images représentant des images pornographiques12, violentes ou haineuses. Si vous demandez une image de deux hommes s’embrassant, il crée une image de deux hommes s’embrassant. Si vous demandez une image de deux femmes s’embrassant, vous recevez une alerte (flag) pour avoir demandé un contenu explicite. Nous avons donc un exemple très clair de la manière dont les valeurs culturelles s’inscrivent dans l’imagerie de l’IA. Tout d’abord, à travers l’ensemble de données et ce qui est collecté et formé. Ensuite, par des interventions dans ce qui peut être demandé. 13

Le choix des mots ou des notions interdites est de la responsabilité des détenteurs de ces outils. Leurs choix d’humains, leurs biais, leurs peurs et leurs précautions produisent des espaces inatteignables au sein de l’espace latent. L’histoire récente montre que laisser aux grandes entreprises technologiques la maîtrise et la monétisation du langage est un grave danger.

« La plus belle femme du monde » renverra plus sûrement Claudia Schiffer que Naomi Campbell . « Un homme de confiance » renverra plus sûrement un banquier en costume qu’un maçon en bleu de travail. Les algorithmes et les jeux de données, ont des biais. Ils sont le miroir déformant d’un monde déformé. Pour corriger la sur-représentation de certaines populations, l’assignation de certaines autres, les biais de genre ou de race, les outils d’IA en sont réduit à des approches assez piteuses. Lire le fil de Mathis Hammel.

Le capitalisme sémiotique, dont Olivier Etzscheid annonce l’avènement, étend sa domination en générant une normalisation, un contrôle toujours accru des mots, des images et du sens, au service de ce que McKenzie Wark et Christophe Degoutin nomment la classe vectorialiste, un nouveau développement du pouvoir capitaliste dont l’intérêt se porte sur le contrôle des données et de l’information, sur la simulation, la computation et la surveillance.

Et les graphistes, là-dedans ?

J’ai demandé à une IA (GPT 3) de quelles manières le métier d’illustrateur va évoluer avec l’arrivée des IA. Voici sa réponse : « Pour survivre dans un tel environnement, l’illustrateur devra renoncer à sa révérence presque superstitieuse envers la créativité.». — tweet d’Étienne Mineur

Le postulat d’Étienne Mineur est que certaines activités vont disparaître ou décroître (concept artist, illustrateurs, designers textiles) au profit des IAs, bien plus rapides et moins coûteuses pour itérer rapidement autour d’une idée, d’une image. Pour lui, les IA sont un outil formidable d’idéation, de création de moodboards, d’exploration de pistes et d’univers graphiques dans lequel le designer devient directeur artistique et curateur bien plus qu’exécutant.

Ces outils s’intégreront également, au prix fort, aux suites logicielles hégémoniques (👋 Adobe) ainsi qu’à quelques outils alternatifs, bientôt rachetés par de plus gros poissons.

C’est davantage autour des questions d’usage que devront se positionner les graphistes, avec une nécessité renouvelée de travailler dans le cadre du sens, et plus seulement (ça n'a jamais été le cas, mais l'enjeu augmente…) au niveau esthétique. Aller là où la machine ne peut pas aller : faire du design, penser en termes de relations.

Depuis Gutenberg, l’évolution technologique a toujours généré des technicités spécifiques, fait émerger de nouveaux acteurs et causé la disparition de certains métiers liés à la création. Les outils de l’IA s’inscrivent dans cette histoire. Mais la place des artistes et des designers reste –tout en produisant de l’imaginaire– de convoquer du sens.

L’imaginaire des IA, quelque soit sa virtuosité et son impressionnante capacité de réinterprétation, de remix, est circonscrit, par définition aux images déjà existantes. Mais la place des artistes et des designers reste pour l’instant centrale dans la création du sens, et dans leur capacité à interroger le monde.

Ce que font les écoles d’art, c’est permettre qu’émergent des questionnements, des positionnements critiques, de modes singuliers de relation entre fond et forme qui restent pour l’instant inaccessibles aux outils de génération visuelle.

Si ces outils poursuivent leur progression, nul doute qu’ils mettront à mal une large part de l’écosystème de certains métiers de la création. Mais on peut se poser la question de la pertinence d’aller dans cette direction : est-il souhaitable de laisser aux machines, compte-tenu de leurs biais, la charge de produire les imaginaires à venir ?

Playgrounds & démos

Texte

OpenAI (GPT-3, payant) Free GPT-J Playground (GPT-J) Jasper.ai, peut générer texte et images Writesonic, « le seul rédacteur IA au monde qui vous aide à écrire des articles de blog et des articles longs (jusqu’à 1500 mots) optimisés pour le référencement, de long format (jusqu’à 1500 mots) en 15 secondes. »

Images

Craiyon

Dall-E

Midjourney (via Discord)

Dream Studio Lite (Stable diffusion)

Noonshoot, un prompt helper qui « aide » à la création de prompts pour Midjourney

Hugging Face, the AI community building the future 🤗, le « GitHub du machine learning » dédié au traitement du langage naturel

Disco diffusion, un ensemble de code exécutable depuis le navigateur ; connexion à Google drive nécessaire.

nightcafe.studio, « Créez des œuvres d’art étonnantes en utilisant la puissance de l’intelligence artificielle. »

Photo restoration with GFP-GAN, restaurer de vielles photos, ici aussi

Photosonic, « l’IA qui peint vos rêves en pixels - gratuitement. »

Artbreeder collager, « réalisez un collage simple à partir de formes et d’images, décrivez-le à l’aide d’un prompt et regardez Artbreeder lui donner vie. »

Son, 3D & vidéo

CogVideo, Text to video

makeavideo.studio, Make-A-Video with text

Runway, AI Magic Tools (voir aussi ça)

Curves to Roads V2, un outil pour dessiner des routes dans Blender

Phenaki, un modèle pour générer des vidéos à partir de texte, avec des prompts qui peuvent changer au fil du temps.

3D-aware Portrait Synthesis, synthèse de portraits tenant compte de la 3D

Mubert, text to music

Code

Copilot, un outil de Github / microsoft pour écrire du code à votre place. En complément, lire How GitHub Copilot could steer Microsoft into a copyright storm.

Tout en vrac

Reconnaissance faciale : Clearview AI écope d'une amende pour son utilisation de données biométriques Intelligence artificielle: en Chine, un logiciel capable de “lire les pensées”

L'Intelligence artificielle ou l'enjeu du siècle. Anatomie d'un antihumanisme radical, Éric Sadin ; lire L’intelligence artificielle, elixir amer ou écouter Critiques de l'intelligence artificielle dans La Terre au carré sur France Inter.

Sur Monoskop, des ressources sur les travaux récents entre l’art/le design et les réseaux neuronaux artificiels dans l’apprentissage automatique.

Experiments with google, de nombreux exemples liés à l’IA (TensorFlow, notamment).

The Stable Diffusion Discord has a channel devoted to spectacular failures and it’s full of gems (ꖛfailed-diffusions channel)

Clipdrop, un écosystème d’applications, de plugins et de ressources, alimenté par l’intelligence artificielle. (Cyril Diagne)

Inondées d’images générées par l’IA, certaines communautés artistiques les interdisent complètement

["IA Art" : comment la technologie révolutionne le geste artistique](), Le Meilleur des mondes sur France culture, avec Gregory Chatonsky, Takyon 236, Carla Marand et Boris Dayma.

Intelligence artificielle : j’aurais voulu être un artiste, La science, CQFD sur France culture, avec Justine Emard, Hugo Caselles-Dupré et Camille Lenglois.

Loab est le nom d’une entité générée par l’IA qui a été invoquée par l’artiste multimédia Supercomposite (attention, images assez effrayantes…).

Un outil pour explorer 12 millions des images parmi les 2,3 milliards utilisées pour entraîner l’algorithme Stable Diffusion.

Création sous caution : les pudeurs de l’IA

How to Read an AI Image, The Datafication of a Kiss

Microsoft Tay: https://fr.wikipedia.org/wiki/Tay_(intelligence_artificielle) + Sexisme, racisme et souverainisme de l’intelligence artificielle

Les Nations unies contre Terminator, Laborieux consensus pour l’interdiction des « robots tueurs »

Pad

Cliquez sur le lien ci-dessous pour contribuer au pad, mettre des liens, textes, ressources et références en commun pour partager la parole et nourrir le débat ↓

-

-

Dans son premier recueil I, Robot, Isaac Asimov (1920-1992) définit trois lois relatives aux robots.

↩Les lire ?

« 1. Un robot ne peut porter atteinte à un être humain, ni, restant passif, permettre qu’un être humain soit exposé au danger. ¶ 2. Un robot doit obéir aux ordres que lui donne un être humain, sauf si de tels ordres entrent en conflit avec la première Loi. ¶ 3. Un robot doit protéger son existence tant que cette protection n’entre pas en conflit avec la première ou la deuxième Loi. » -

Completely Automated Public Turing test to tell Computers and Humans Apart, ou « Test public de Turing complètement automatique ayant pour but de différencier les humains des ordinateurs ». ↩

-

En 1965, Gordon Moore, cofondateur d’Intel, proposait que la puissance informatique serait en mesure de doubler tous les 18 à 24 mois. Depuis lors, cette hypothèse s’avère relativement exacte. ↩

-

-

L’attirance que certain⋅es d’entre elles⋅eux manifestent pour les NFT n’étant pas leur plus grande qualité, on découvrira leur travail et leur recherche sans trop chercher la petite bête. ↩

-

Reconnaître une forme familière dans un paysage, un nuage, de la fumée, une tache d’encre… ↩

-

Le paradoxe du singe savant est un théorème selon lequel un singe qui tape indéfiniment et au hasard sur le clavier d’une machine à écrire pourra « presque sûrement » écrire un texte donné. — Wikipédia ↩

-

Par la grâce du web, de l’informatique et de Jonathan Basile, la bibliothèque de Babel existe bel et bien. ↩

-

-

-

Aujourd’hui, de nombreux outils ont moins de pudeur, et ont ouvert la voie à une production pornographique dont on peine à percevoir l’ampleur des ravages à venir. ↩

-

Olivier Errtzscheid, toujours. Pour poursuivre sur les biais algorithmiques, lire également Les perroquets stochastiques et l’attaque de la typographie géante. ↩